Glimpse Ahead Unpluged ~ 2019年のコンピューティング世界を読み解く

みなさん、こんにちは。

今回はマイクロソフトが10年後の未来におけるコンピューティングの姿を描いたビデオ “Glimpse Ahead” を読み解いていきたいと思います(※)。

“Glimpse Ahead” にはいくつかのバージョンがあるのですが、今回は以下の内容を元ネタにしたいと思います。

では早速ですがオープニングシーンから。

オープニングシーンは、小学生2人が透明なガラス越しに会話をしているシーンから始まります。 女の子が英語で話をすると、男の子の見ているガラスには、英語の文章とヒンディー語が併記されて表示されます。 (私、猫を飼っているんだけど、あなたは何か飼っている? いや、飼ってないよ) さらに、”DID YOU KNOW” の言葉とともに、インドでは猫は不吉なシンボルなんだよ、という豆知識が。 実はこの2人、ガラス越しで会話をしていたのではなく、巨大なディスプレイを使った遠隔コミュニケーションをしているのです。 ヒンディー語「पानी」("Paani") の字をなぞると Water の訳と雲の絵が。 この小学校(とインドの小学校)では、距離的、時間的、文化/言語的な壁を越え、生徒同士が自由にコミュニケーションできる環境を用意していました。 |

さて、ここでいったん現代に戻って、この10年後のコンピューティングの姿にたどり着くために、現在用意できているものを確認しましょう。

まず一つ目が、「巨大なマルチタッチ可能なディスプレイ」。

本当に教室の壁一面を使ったようなディスプレイで通信しあうことができるのでしょうか?

その答えの一つ目。

上記の施設は、マイクロソフトの本社(レドモンド)にある Microsoft Technology Center にあるディスプレイです。

このディスプレイはリアプロジェクションになっており、ディスプレイの後ろから画像を照射することで像を映していますが、あわせて後ろには「タッチ」されたことを感知するためのカメラが設置されており、それによってディスプレイ上の画像をドラッグしたり回転させたりすることが可能です。

同様の仕組みで製品化されているものとしては Surface があります。

Surface では、画像はテーブルの下部から照射されており、それをディスプレイ部で受けて像を映しています。また、テーブルの下部には5つのカメラがあり、ディスプレイ部にタッチ(あるいは物が置かれると)された情報を画像情報として受け取って、それを処理しています。

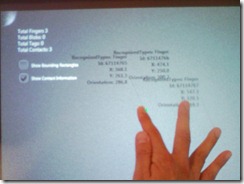

下記は Surface に3か所指を付けて、座標認識をさせているところ。

50本くらいまで認識OKのようで、場合によっては100本近く認識できるとか。

ついでに下記は Surface において、ディスプレイにタッチした(置いた)物体をどのように画像認識しているかの写真。

それぞれ Surface のディスプレイ上においた物体の認識情報が鏡のように(上下逆に) Surface 上に表示されています。一番左の円錐型のオブジェクトには、裏面に Microsoft Tag とよばれる2次元バーコードが張っており、それが認識されているのがわかります。真ん中の葉っぱのオブジェクトにも Microsoft Tag が張られています(今回、Tag を見ていただくために反対におきました)。一番右が手のひらですが、今回はベタッとおいたので、全体が認識されています。

このように、後方プロジェクター&カメラの組み合わせによるマルチタッチの認識はすでに Surface で実用化されており、タッチ入力の認識精度、速度も非常に速い(快適)です。

Glimpse Aheade に出てきた、「巨大なマルチタッチ可能なディスプレイ」、も要素技術的にはこの延長でできそうです。

また、言語認識に関しては、マイクロソフトにおいては Office Communication Server や Exchange Server において既に実用的に利用しています。これらのテクノロジーを使用すると、たとえば、車の運転中などに携帯電話を持てないとき、音声認識によって携帯電話を操作し、新着メールを聞いたり、返信したり、といったことが可能になります。

また、開発者向けにライブラリやAPIを公開していますので、これらのテクノロジーを使用したアプリケーション開発は今すぐにでも実施いただけます。

(詳しくは 「Microsoft Speech Technology」 ページをどうぞ。ちなみにこれらのサーバーで、超べたべたな日本人発音でしか英語を話せない私がアクセスすると、結構苦労しました。)

次に、音声認識を行った文章を翻訳する。これに関しては、「Bing Translator」が一つのサンプルになるかと思います。また文化翻訳(インドでは猫は不吉、云々、といった豆知識)は、エンカルタや、Wikipedie のような情報を、コンテキストに合わせて表示することで実現できそうです。

引き続き、次のシーン。

飛行機に乗っている女性がディスプレイを見ています。 ディスプレイには、先ほどの小学校で女の子たちが書いていた Water の絵が。どうやら、遠隔地での授業参観のようです。もちろん、このディスプレイもマルチタッチ可能。 授業参観の様子を小さくすると、スケジュールフォルダに収まります。そして今度は仕事のスケジュールを確認。 おもむろに、本に挟まった”しおり”を抜き出すと、、、、 実は”しおり” ではなく、搭乗券。 しかも、指でタッチすると画面が切り替わり、到着時間が表示されます。 |

さて、同じように現在実現しているテクノロジーに関してみていきましょう。

薄型のマルチタッチディスプレイは先ほどの小学校のシーンより、実現可能なように思えます。

むしろ、搭乗券のような小型ディスプレイが気になりますが、、、、、

実はタッチ認識可能な、薄型のディスプレイは Microsoft Research と Tronto 大学、Mitsubishi Electric Research Lab (三菱電機) の共同研究で、以下のようなモックが作成されています。

モバイルデバイス用の液晶技術の進歩も見逃せません。

下記はベンチャー企業 Liquavista 社が開発している、水と油が反発し合うという特性を利用したディスプレイ技術 “Electrowetting”。

少量の着色された油と水、そして電圧をかけると水と反発する疎水性から親水性に変わる素材を用いたレイヤで構成されており、電圧によりディスプレイ表示を操作することが可能だそうです。

ということで、この飛行機におけるシナリオも実現できそうです。

どんどん進みましょう。

次のシーンはオフィスです。 巨大な “透明” ディスプレイを使って、男性が仕事を進めています。 このディスプレイももちろんタッチ可能。 よっこらせ、と席に座ると、、、、 3面のディスプレイと、その下にサブディスプレイと、入力用(?)の透明な板のあるデスク。 サブディスプレイをタッチすると、メインのディスプレイに表示される情報が変わります。 さらに、、、、、ぐっと手を前に押し出すと、 表示されている情報が横に倒れます。 引き続き作業を進めた男性は、最終資料を持ち運び可能なデバイスにコピーします。 コピーしたい資料に左手の指を付けて、右手の指で、 ぐっぐ、とコピーしたいデバイスの近くまでドラッグします。 すると情報がコピーされました。 情報がコピーされたデバイスをもって、会議室に移動です。 |

このシーンにおけるテクノロジーも、なんとなく、実現できそうです。

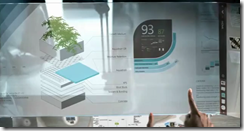

まず、この男性が使っている机に似たものが、前述したマイクロソフト本社の Microsoft Technology Center にはあります(下記)

さらに、”手を押し出すジェスチャー” でディスプレイを操作していたシーンは、今年の年末最大の楽しみ(?) Kinect でこちらも実現済みなテクノロジー。

Kinect は Xbox 360 用のハードウェアで、開発時のコードネームは Natal。

Kinect のセンサーがプレーヤーを認識し、コントローラーを使うことなく、ジェスチャー(体全体の動き)と声によって、ゲームをプレイすることが可能です。

2011年の予定ですが、Star Wars も出るらしいです♪

※ Kinect は北米では今年の11月の発売予定。日本では未定のようです。詳しくはプレスリリースを。

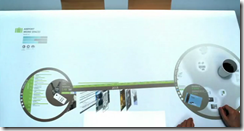

また、デバイス間のデータのコピーに関しては、たとえば Surface にある以下のようなアプリ。

このアプリでは、2つのオブジェクト(コインのようなオブジェクト)にそれぞれ情報を関連付けており、指によるジェスチャー操作によって、その情報をそれぞれのオブジェクト間で移動させることが可能です。

また、ディスプレイをまたぐ情報のやり取りは、パイオニアが Windows 7 を使って実現した「ディスカッション テーブル」でも実装されています。

(テーブル上のディスプレイから、ジェスチャーにより奥にある縦置きのディスプレイに情報を投げたところ。詳しくは

https://ascii.jp/elem/000/000/482/482127/index-2.html)

次に、”透明” なディスプレイ。

デンソーが「FPD International 2006」で展示した無機ELディスプレイ、がよいかもしれません。

(日経BP社の記事(登録が必要です)。https://techon.nikkeibp.co.jp/article/NEWS/20061018/122412/?ST=fpd)

また、タッチ可能なものとしては、慶應義塾大学SFC 環境情報学部の LimpiDual Touch というものもあります。

https://www.xlab.sfc.keio.ac.jp/?page\_id=98

参考:寺岡精工 Elexy https://www.rosa.co.jp/Construct/ELEXY/img/ELEXY01.wmv

ということで、こちらも要素技術的には実現できそうです。

引き続き次のシーン。

空港で男性が歩いています。 手には全面ディスプレイのデバイスが。 実はこれ2つに分割できます。 しかも、先ほど飛行機の中で遠隔授業参観していた女性から、電話がかかってきたようです。 電話に出る男性。 セパレート携帯で、ビデオ通話、、、、だけでなく、会話が翻訳されて字幕で出てきます。

電話を切った男性が携帯で女性の位置を確認すると、携帯がその位置までナビゲート。

さて、場面はいったん会社に戻ります。 巨大ディスプレイを使いながら、遠隔地の女性を含めてミーティング中。 そこに先ほどの男性(マルチディスプレイを使って働いていた男性)がやってきて、手元のデバイスから、会議室のディスプレイに情報をジェスチャーで移動。 先ほどデスクでまとめていた情報を共有します。 会議でタスクとしてまとめられた情報は、音声認識でメモされます。

さて、場面は空港に戻ります。 飛行機を降りた女性が待合室で待っています。 ここの机も、コンピューター。 彼女の持ち物をキーとして、必要な情報を表示しています。 先ほどの男性がやってきました。 おもむろに「鍵」をテーブルに置く男性。 するとその鍵をもとに、男性の情報が表示されます。 それを、女性の情報と結びつけると、2人のこれまでの情報のやり取りの履歴が。 その中で、気になった画像をピックアップすると、、、、 画像が疑似3Dとして表示されました。 |

さて、まずは男性が持っていた携帯電話。

このビデオは2009年に、「10年後の未来像」として、設定 2019年で出されたものですが、今年 2010年、セパレート化携帯がすでに商用化されています。富士通が作った Docomo の携帯 docomo PRIME series F-04B。

まさにセパレート携帯です。

さらに、電話を切った後に携帯が道案内をするシーン。

実はこれ、空港の床がナビゲーションをしているのではなく、携帯が行き先を床に投影することで実現している設定になっています。

ということで、これの関連技術としては Pico Projection。

https://dlp.com/pico-projector/

超小型のプロジェクターで、Texas Instruments が「DLP テクノロジー」をコアに提供している技術です。3D投影も可能になるとか(下記は3D投影のイメージ)

で、この Pico Projection は、実は、先に紹介した富士通が作った携帯 docomo PRIME series F-04B でオプション品としてすでに実用化、提供されています。。。。富士通さんすごい!!

ということで、彼が使用している携帯の機能も、要素的には実用化されており、あとは小型化が進めば、という感じです。

会議室のシーンで出てくる、巨大ディスプレイを使った遠隔地会議、デバイス間での情報のやり取り、音声認識、といった技術はすでに前述しているので、ここでは説明を省きます。

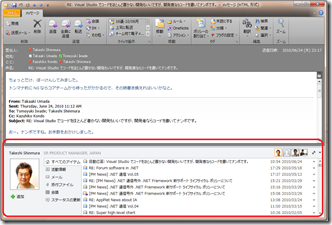

空港で待ち合わせた女性と男性のシーンですが、2人の間に表示されるコミュニケーションの履歴。

これは、最新の Office 2010 の Outlook の中ですでにあります。

上記は、同僚のS氏から送られてきたメールですが、メールの下部に、最近S氏とやり取りしたコミュニケーション(メール、会議、チャット)の履歴が表示されます。

さらに、コミュニケーションの履歴の中から疑似3Dの画像を表示するシーンですが、こちらもすでにおなじみ(?)の PhotoSynth(フォトシンス)。として実用済みのテクノロジーです。

PhotoSynth は複数の写真データをもとに、疑似3Dの世界を作り出すテクノロジー。

お台場に展示されていたガンダムも、PhotoSynth で疑似3Dに。

(PhotoSynth のページで、gundam で検索するとこれ以外にも結構ありますよ♪)

では、いよいよ最後のシーン。

2019年の世界ではコーヒーカップもインテリジェンス。 おもむろに新聞を読みだす男性。 ビデオニュースが表示されているうえに、ジェスチャーで読みたい情報を選び出すことができます。 壁にあるディスプレイには、家の電力消費状況が表示されているようです。 リモコンを使って操作。 さらに、出てきた情報を、リモコンで透かして見ながら、操作すると、リモコンにデータがコピー。 さらにリモコンから新聞にデータをコピーします。

さらにシーンが変わって、植物が映し出されます。 植物の輪郭が縁どられて、情報が表示されます。 植物を直接見ていたと思ったら、透明のディスプレイを通してみていたのでした。 空港で待ち合わせていた女性と男性が会話。 都市の緑化プロジェクトを推進していたようです。 未来の都市像が映し出されます。 |

このシーンでもいくつかの要素技術はすでに出てきたもので構成されていますので、気になる2つのテクノロジを。

まずは、コップ、あるいは新聞型のコンピューターですが、そもそもそんなディスプレイができるのか、という回答の一つが SONY の OLED ディスプレイ。この曲がり方、すごいです。

もう一つ、気になるのがリモコンをかざしてデータをコピーするシーンや、植物を見ながら情報を重ね合わせるシーン。

これも、AR(拡張現実。Argumented Reality) としてたとえば頓智ドットのセカイカメラや、Android の星座早見盤アプリで要素的には実現済みです。

さて、最後にもう一つ。

Glimpse Ahead では様々な魅力的なデバイスが登場しますが、これらがすべて個別のコンピューターとして動作しているわけではありません。基本的には、それぞれのデバイスは「クラウド デバイス」として、ディスプレイと人間による入力を受け付ける役割を中心にになっており、データや処理に関してはクラウド上のコンピューティングリソースと連携しながら実現しているシナリオになっています。

逆にクラウドのリソースを前提にすることで、どこでもコンピューター(ユビキタス コンピューター、とかアンビエント ディスプレイとか)が実現しています。

そして、クラウドコンピューティングについては、Windows Azure という形で実現が始まっています。

ということで、今回は Glimpse Ahead を題材に未来のコンピューティングの姿についてエントリしてみました。

夢のようなビデオにも見えますが、意外と実現できそうな気がしますね。

そして、日本の企業や大学の技術もすごいです。富士通のセパレート携帯 F-04B のように、ぜひ 2019年といわず、どんどん先駆けて実現してほしいです!

最後に、実際にこんな小型デバイスで、ビデオに出てきたような処理をこなすことができるのか、という点については、ソフトバンク孫社長による「新30年ビジョン」をどうぞ。2018年には、ワンチップで人間の脳に相当する計算を実行できるようになるそうです(ツイッター総研による書き起こしもいいですよ)。

とても長いエントリになってしまいましたが、最後までお読みいただきありがとうございました。

それでは!

※ シリーズ名は今回なしで ;-)