SharePoint Configuration Best Practices - Request Management Service

SharePoint Adventskalender - 17. Türchen

Performance Tuning - Performance Monitoring - Best-Practices für SP-SQL-Konfigurationen - BLOB Management - Backup & Recovery

-------------------------------------------------------------

Bei dem heutigen Thema schauen wir uns einen weniger bekannten Service an, der jedoch sehr interessante Funktionen für uns bereit hält. Die Rede ist vom Request Management Service. Dies ist eine Art Load Balancer hinter dem Load Balancer. Damit kann SharePoint selber bei ankommenden Anfragen entscheiden, ob wirklich der vom Load Balancer zugewiesene WFE die Anfrage bearbeitet, oder ob noch einmal zu einem anderen WFE geroutet wird.

Ein Load Blanacer, wie der F5, arbeitet für ein Netzwerk-Load-Balancing während das Request Management (RM) auf Application-Eben die Last verteilt. Dazu können Throttling Regeln zum „bremsen“ und Routing Regeln zum priorisieren verwendet werden. Der Service ist standardmäßig ausgeschaltet, aber kann pro Web Application über PowerShell konfiguriert werden.

Funktionsweise:

Jedem Server kann über PowerShell ein statischer „Health“-Wert gesetzt werden. Zusätzlich prüft SharePoint alle 5 Sekunden die dynamische „Health“ jedes WFE Servers. Die Skala geht von 0 („am gesündesten“) bis 10. Bekommt ein Server drei mal hintereinander den Wert 10 (z.B. weniger als 20 MB RAM verfügbar), drosselt das RM die Anfragen auf diesem Server. Damit kann verhindert werden, dass ein Routing vom Load Balancer zu einem hängenden Server keine Fehlermeldung beim Endnutzer generiert. Stattdessen wird die Anfrage neu geroutet. Der Request Service fungiert praktisch als Proxy und erstellt eine neue Anfrage, die der alten zwar gleicht, jedoch zu einem neuen WFE geht.

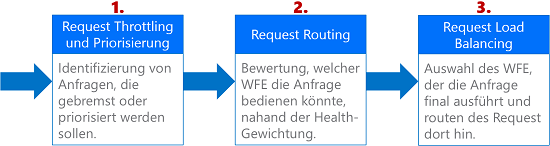

Ablauf:

Zunächst kommt eine Abfrage vom Endnutzer oder vom Load Balancer am SharePoint an.

- Dieser evaluiert den Request anhand definierter Regeln. Diese können Eigenschaften (Url, UrlReferrer, UserAgent, Host, IP, HttpMethod, SoapAction, CustomHeader) oder Methoden (StartsWith, EndsWith, Equals, RegEx) überprüfen.

- Mögliche Server werden anhand der Regelkriterien und/oder der Server-Gesundheit identifiziert (siehe Bild unten)

- Nach Identifizierung des Servers wird der Request dorthin geroutet (bzw. gebremst, bei Throttling Regel).

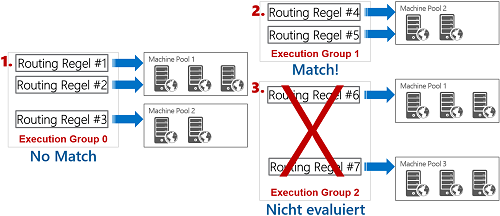

Regeln werden innerhalb von drei Gruppen (Execution Groups 0 bis 2) zusammengefasst und entsprechend priorisiert. Diese Gruppen repräsentieren Servergruppen, zu denen geroutet werden soll.

- Gruppe 0 wird als erste geprüft.

- Gibt es keinen Match, werden die Regeln von Gruppe 1 geprüft.

- Gibt es ein Match, werden alle Regeln einer niedrigeren Priorität (Execution Group 2) verworfen und der Request direkt bearbeitet.

Gäbe es auch in Gruppe 2 keinen Match, dann wird der Request zu irgendeinem Server geleitet – aber nur dann, wenn ich mindestens in die letzte Gruppe auch eine Art „Catch-All“ Regel definiere, die alle nicht geregelten Anfragen abarbeitet (sollten keine weiteren „freien“ WFE außerhalb der Execution Gruppen existieren).

Vorteile:

- Ablehnen gefährlicher Anfragen (z.B. von bestimmten Quellen)

- Priorisieren von Anfragen basierend auf Server-Health und Regeln (z. B OneNote Verkehr immer über Server1; Search Crawler immer auf Server4; neuere Server mit mehr Resourcen können mehr Anfragen übernehmen, etc.)

- Anfragen können „umgeschrieben“ werden mit beispielsweise sogar einem anderen Port

- Traffic Isolierung zur Fehleranalyse (z.B. von einer bestimmten Site Collection zu einem bestimmten Server)

- Regeln kann man auch ein Ablaufdatum mitgeben, sodass spezielle Routings automatisch enden

Nachteile:

- Zusätzliche Last auf den WFE-Servern durch den RM Service

Oder besser: Den RM Service auf einem dedizierten Server laufen lassen, z.B. gemeinsam mit einem Distributed Cache Service

Beispiele:

Erstellen einer Routing Regel, um alle Anfragen für Word Dokumente für Web Application https://intranet.contoso.com zum WFE „Server1“ zu leiten.

- Request Manager Service auf den WFEs aktivieren:

- Central Administration im Browser öffnen

- Zu Manage Services navigieren

- Request Management Service starten

- Scope der Web Application referenzieren

- $WebApp = Get-SPWebApplication -identity https://intranet.contoso.com

- RM Service auf die Web Application referenzieren

- $RM = $WebApp | Get-SPRequestManagementSettings

- Erstellen eines neuen Filter-Kriteriumsmit der “Url” Eigenschaft und RegEx für alle Dokumente vom Typ DOCX

- $Krit = New-SPRequestManagementRuleCriteria -Property Url -Value ".*\.docx" -MatchType Regex

- Sollte dies die erste Regel sein, die wir erstellt haben, müssen wir auch einen Server-Pool erstellen, zu dem diese Anfragen geroutet werden sollen.

- $Pool = Add-SPRoutingMachinePool -RequestManagementSettings $RM -Name AdventsPool -MachineTargets ($RM | Get-SPRoutingMachineInfo -Name Server1)

- Nun kann die Routing-Regel mit obigen Server-Pool und Filter-Kriterium angelegt werden

- $RM | Add-SPRoutingRule -Name "DOCX Regel" -Criteria $Krit -MachinePool $Pool

- Fertig und testen! (ULSViewer is your friend…)

Erstellen einer Throttling Regel, um Anfragen von OneNote auf die Web Application https://intranet.contoso.com zu bremsen, wenn der Health-Wert 8 ist.

- Scope der Web Application referenzieren

- $WebApp = Get-SPWebApplication -identity https://intranet.contoso.com

- RM Service auf die Web Application referenzieren

- $RM = $WebApp | Get-SPRequestManagementSettings

- Hinzufügen eines neuen Kriteriums für OneNote 2010 Anfragen. Dies kann über den UserAgent im Request realisiert werden.

- $Krit = New-SPRequestManagementRuleCriteria -Property UserAgent -Value ".*Microsoft Office OneNote 2010*" -MatchType Regex

- Nun fügen wir die Throttling Regel für die Server-Health 8 hinzu.

*Hinweis: Throttling Regeln gelten im Gegensatz zu Routing Regeln für die gesamte Farm und nicht für einzelne Server(-Pools). Daher müssen wir hier keinen Server-Pool mit angeben.- $RM | Add-SPThrottlingRule -Name "OneNote Throttle Rule" -Criteria $Krit –Threshold 8

Viel Spaß beim „SharePointen“

-------------------------------------------------------------

Weitere Türchen:

- 1. Türchen: SharePoint Performance Tuning - Cluster Größe der SQL Festplatten

- 2. Türchen: SharePoint Performance Tuning - SQL Speicherzuweisung

- 3. Türchen: SharePoint Performance Tuning - SQL MAXDOP

- 4. Türchen: SharePoint Performance Tuning - SQL AutoGrowth-Einstellungen

- 5. Türchen: SharePoint Performance Tuning - SQL Datenbanken vor konfigurieren

- 6. Türchen: SharePoint Performance Tuning - SQL TempDB Einstellungen

- 7. Türchen: SharePoint Performance Tuning - Der Papierkorb

- 8. Türchen: SharePoint Performance Tuning - Warm Up Skripte

- 9. Türchen: SharePoint Performance Monitoring - Performance Counter für den Prozessor

- 10. Türchen: SharePoint Performance Monitoring - Performance Counter für Speicherlaufwerke

- 11. Türchen: SharePoint Performance Monitoring - Performance Counter für den Arbeitsspeicher

- 12. Türchen: SharePoint Performance Monitoring - Performance Counter für System und Netzwerk

- 13. Türchen: SharePoint Configuration Best Practices - SQL Alias

- 14. Türchen: SharePoint Configuration Best Practices - Benamte SQL Instanzen und dedizierte Ports

- 15. Türchen: SharePoint Configuration Best Practices - Super User und Super Reader

- 16. Türchen: SharePoint Configuration Best Practices - Distributed Cache Service

- 17. Türchen: SharePoint Configuration Best Practices - Request Management Service

- 18. Türchen: SharePoint BLOB Management - BLOB Cache

- 19. Türchen: SharePoint BLOB Management - BLOB Storage (EBS und RBS)

- 20. Türchen: SharePoint BLOB Management - Shredded Storage

- 21. Türchen: SharePoint BLOB Management - Shredded Storage und RBS “Better Together”

- 22. Türchen: SharePoint BLOB Management - Archivierung

- 23. Türchen: SharePoint Backup & Recovery - Von RTO, RPO und RLO zum fertigen Disaster Recovery Plan (1/2)

- 24. Türchen: SharePoint Backup & Recovery - Von RTO, RPO und RLO zum fertigen Desaster Recovery Plan (2/2)