Azure Data Factory- 資訊管線的建立與管理 (技術預覽)

感謝北科大劉建昌同學翻譯微軟公司 Azure Data Factory 團隊主管 Mike Flasko於 2014 年 10 月 29 日所發表的文章 https://azure.microsoft.com/blog/2014/10/29/data-factory-public-preview-build-and-manage-information-production-pipelines/

現代企業資料處理的方式相較過往更為多樣化,資料處理往往需要牽涉到多個不同地理位置的資料,面對位於本地與雲端上的資料,甚至較過去更為多樣化的資料型別與更大的資料量,上述原因都會造成資訊系統過於複雜或是多樣化。也因此開發人員必須撰寫大量的客製處理邏輯,以便協調,處理和管理所有產生出來的資料。

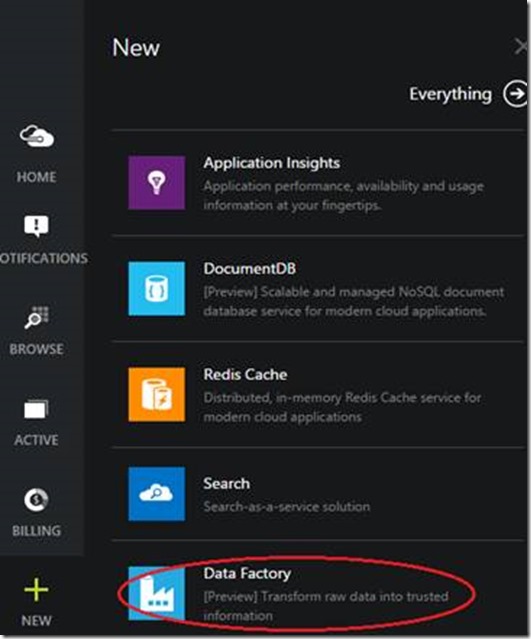

我們很高興的宣布,新的 Azure Data Factory 服務正式進入技術預覽階段,可供所有使用者測試和使用。Azure Data Factory 是一個將資料儲存,資料處理,資料搬移運用產生資料管線 (data production pipelines) 方式處理的雲端服務,您僅需要在 Azure 管理網站上透過幾個簡單的步驟,或是使用命令列操作,就能夠建立一個 Data Factory 並且將其與生產的資訊和資源加以結合。在技術預覽階段的 Data Factory 能夠連接到本地端 SQL Server 或是 Azure Storage Blob、Table 與 Azure SQL Database 上的資料。歡迎您將此預覽階段上使用 Azure Data Factory 的心得回饋給我們,我們將會增加更多種資料來源在這項服務上。

關於 Hadoop 巨量資料的處理,在最一開始都是透過 Hive、Pig 或是 C# 等語言撰寫出的 activites 來進行。這些 activites 可以用來清除資料、遮罩資料欄位 (mask data fields) 或是透過各種各樣複雜方式來轉換資料。Hive 和 Pig 所編寫的 activites 能夠在您所建立的 Azure HDInsight 叢集上運行,或者您也能夠讓 Data Factory 來全權管理整個 Hadoop 叢集的生命週期。透過這項方法,您只需要編寫 activites,並且將他們組合成一個管線 (pipeline),並設定好執行的時程 (execution schedule),您就完成了所有的設定,不需要再進行額外之 Hadoop 叢集的安裝和管理。Azure Data Factory 也提供了即時的監控儀表板,這意味著您能夠在佈署了資料管線 (data pipelines) 的同時,也能夠立刻在監控儀表板上了解整個資料產出與處理的狀態。

目前您已經可以在 Azure 預覽入口管理網站上啟用 Azure Data Factory 服務。

一旦您在 Azure Data Factory 創建和佈署了管線 (pipelines) 之後,您可以快速評估點對點之間數據傳輸的效率,還能夠精準的找到問題點,並在需要的時候採取矯正措施。在 Azure 預覽入口管理網站上,整個資料管線都是以視覺化方式呈現。用戶可以透過圖像了解管線 (pipelines) 之間的相依性,以及資料如何進行輸入與輸出。您還可以透過監控儀表板,得知作業執行狀態 (job execution)、資料生產的狀況與系統健康狀況等詳細資料。最後,利用資料管線 (data pipelines) 的設定,您可以自動從雲端將巨量資料轉換至本地端的 SQL Server 內,或是將轉換完的資料保存在雲端儲存體上,以供應用程式或分析工具來使用。

透過以下方式,我們可以開始使用 Azure Data Factory

- 按照步驟來建立您的第一個管線 (pipeline)

- 瀏覽更多關於 Data Factory 的產品文件

- 參考 Data Factory GitHub repository 範例

- 若有任何問題,可以到 Data Factory論壇 提問

我們很高興您能夠來試用 Azure Data Factory 服務,並且期待您能夠回饋給我們對於 Data Factory 的使用心得。若您有任何想要告訴我們的想法或是意見,可以到此處來告知我們。

這篇文章原始發佈於「Microsoft Azure 中文部落格」