Vélib & Cortana Analytics – Deuxième partie

1 - Introduction

L’équipe SQL/BI de Microsoft Customer Support Services a initié un projet interne d’analyse en temps réel des stations Vélib Parisien. J’ai rejoint l’équipe constituée de Yassine Khelifi, Didier Simon, Émilie Beau et Mathias Ekizian afin de prendre en charge les services Azure Event Hubs, Stream Analytics et Data Factory. C’est à ce titre que je vais présenter en deux articles ces différents services de l’offre Cortana Analytics.

Lien vers le 1er Article : Vélib & Cortana Analytics – Première partie.

2 - Présentation du projet

Vélib est un service public à grande échelle de location de vélos sur la région parisienne en France. Lancé le 15 juillet 2007, le service propose aujourd’hui environ 14 500 vélos et 1230 stations sur Paris.

Grâce à la suite Azure Cortana Analytics Suite, nous allons mettre en place une solution d’analyse des données de ces Vélib de façon à répondre à 2 problématiques :

• Obtenir une analyse descriptive en temps réel du réseau Vélib

• Mettre à disposition une analyse prédictive permettant de prédire la disponibilité du nombre de vélos et de stations disponibles pour une station donnée.

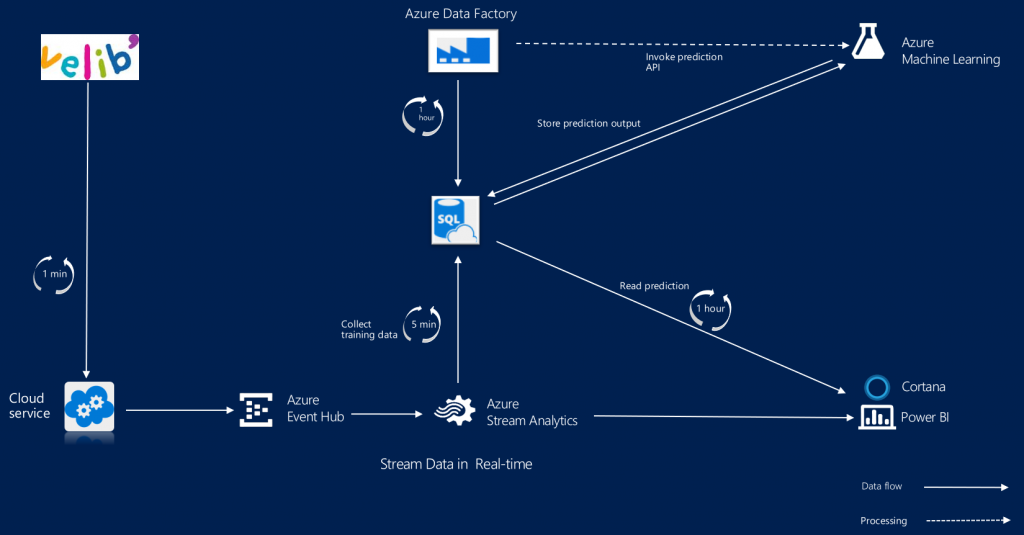

Architecture :

L’API utilisé est celle de JCDecaux : https://developer.jcdecaux.com/#/home

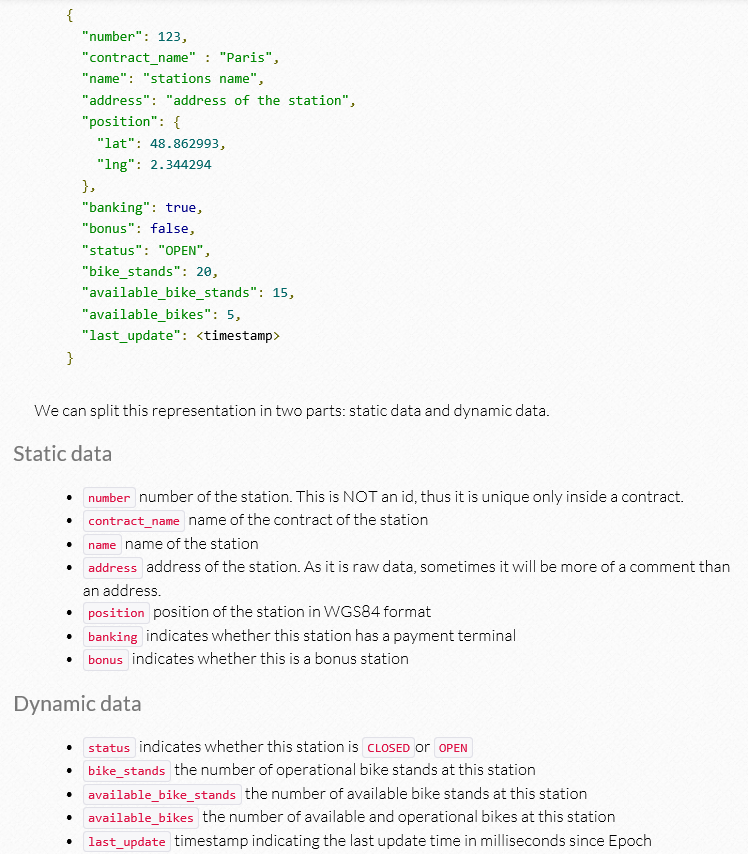

Voici à quoi ressemblent les données sources :

3 - Présentation du Cortana Analytics

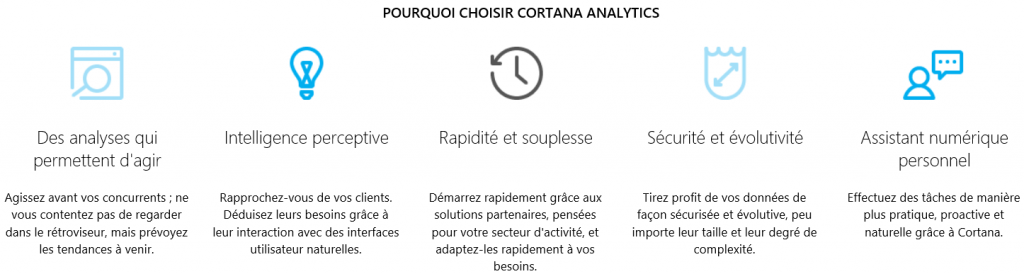

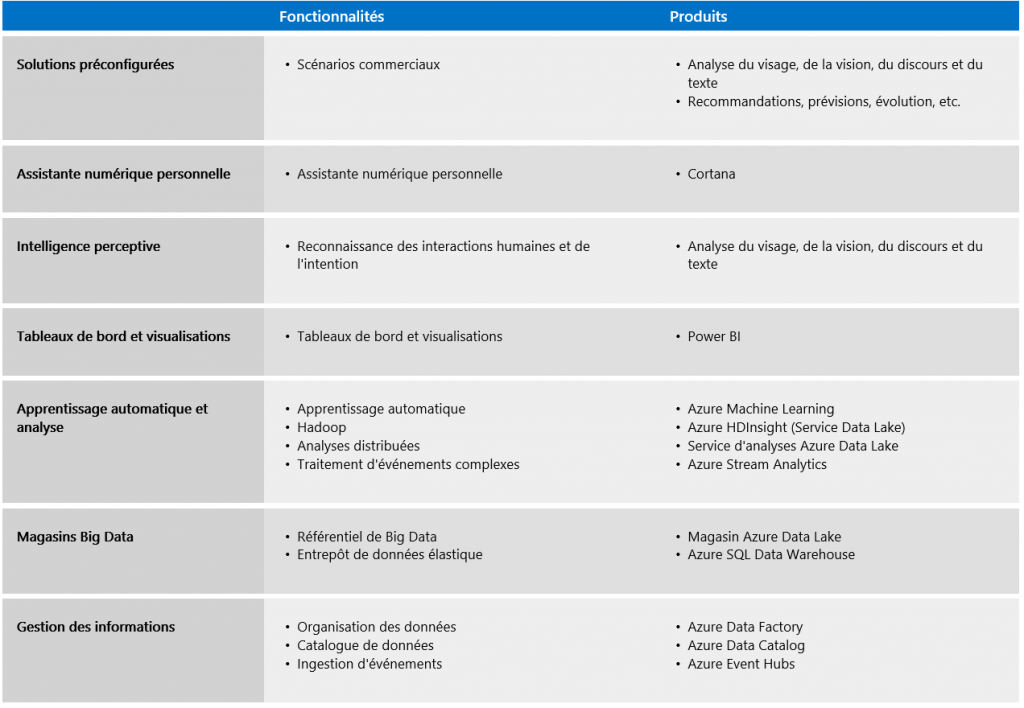

Cortana Analytics est une suite de services intégralement gérée pour le Big Data et les analyses avancées permettant de transformer vos données en actions intelligentes.

Voici les différents services inclus dans Cortana Analytics :

Pour en apprendre davantage sur Cortana Analytics : aka.ms/cortanaanalyticsprocess

4 - Présentation de Azure Data Factory

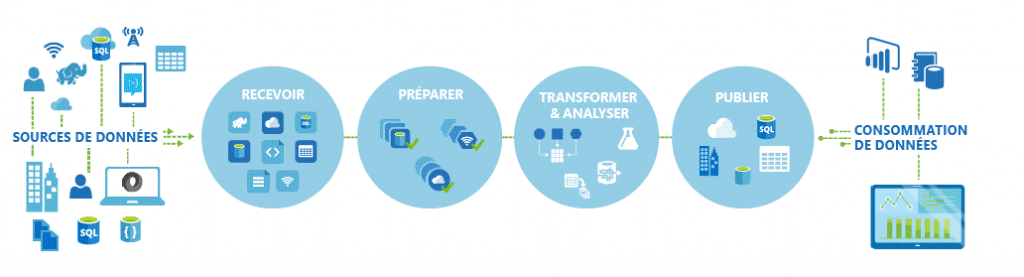

Data Factory est un service d’intégration de données dans le cloud qui gère et automatise le déplacement et la transformation des données. À la manière d’une usine de fabrication, qui utilise des machines visant à transformer des matières premières en produits manufacturés, Data Factory orchestre des services existants qui collectent des données brutes et les transforment en informations prêtes à l'emploi.

Data Factory fonctionne pour des sources de données locales et dans le cloud et avec les SaaS pour réceptionner, préparer, transformer, analyser et publier vos données. Vous pouvez utiliser Data Factory pour constituer des services dans des pipelines de flux de données gérés afin de transformer vos données à l'aide de services tels qu’Azure HDInsight (Hadoop) et Azure Batch pour vos besoins en calcul de Big Data, et avec Azure Machine Learning pour configurer vos solutions d'analyse.

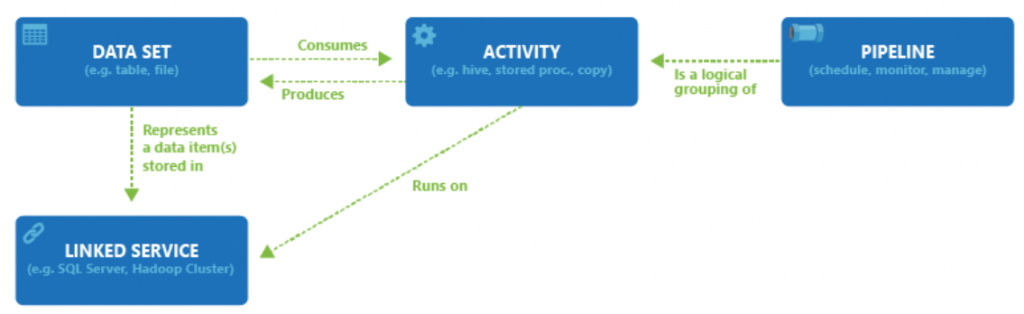

Voici les différents objets d’un Job ADF :

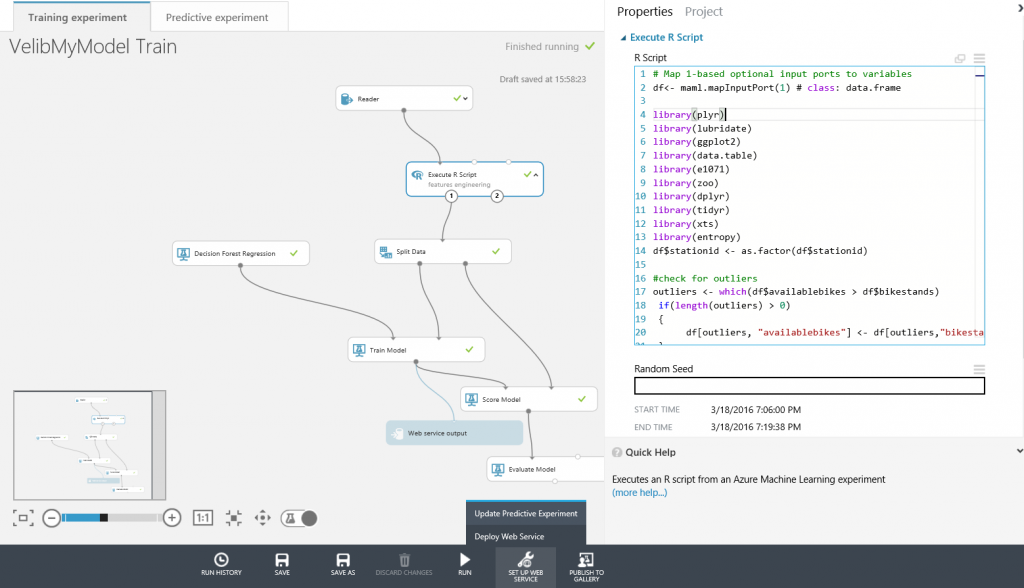

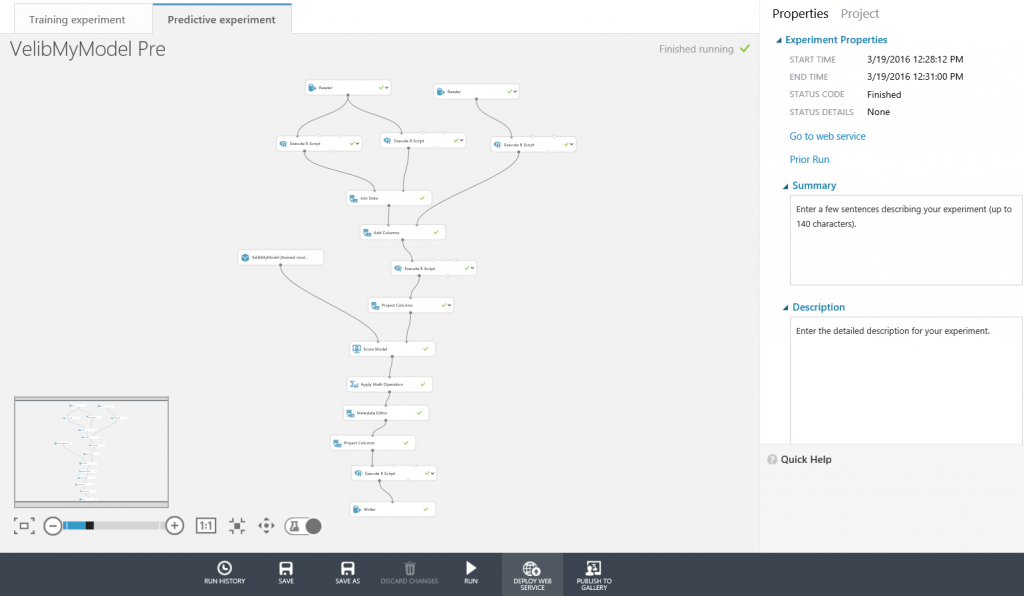

Dans la solution, nous avons utilisé le service Azure Data Factory pour Scheduler l’appel de l’API de prédiction, sauvegarder les résultats dans une base de données Azure SQL Database ainsi que pour ré entrainer et mettre a jours le modèle de prédiction.

Pour ré entrainer un modèle Azure ML : https://azure.microsoft.com/en-us/documentation/articles/data-factory-azure-ml-batch-execution-activity/

Documentation : https://azure.microsoft.com/en-us/documentation/articles/data-factory-alltopcat/

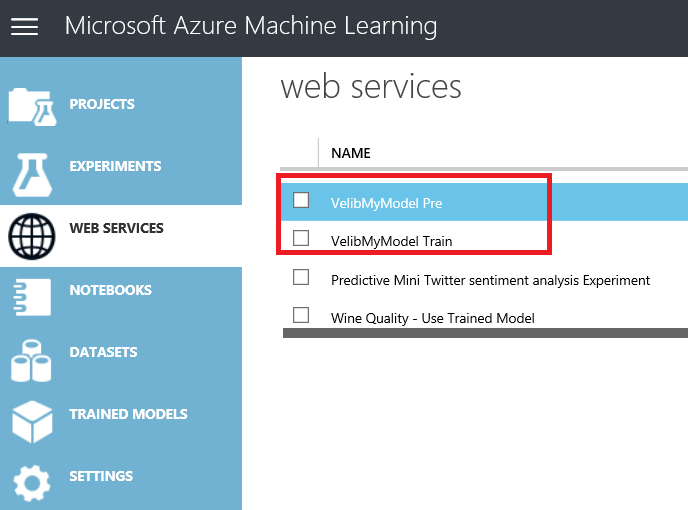

Avant d'initier la Pipeline ADF, il faut créer les Endpoints AzureML:

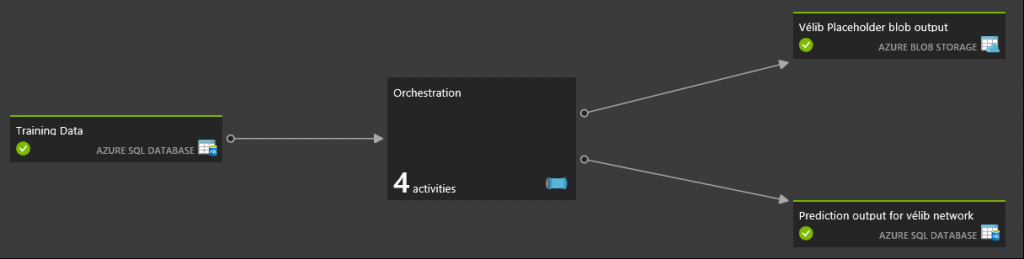

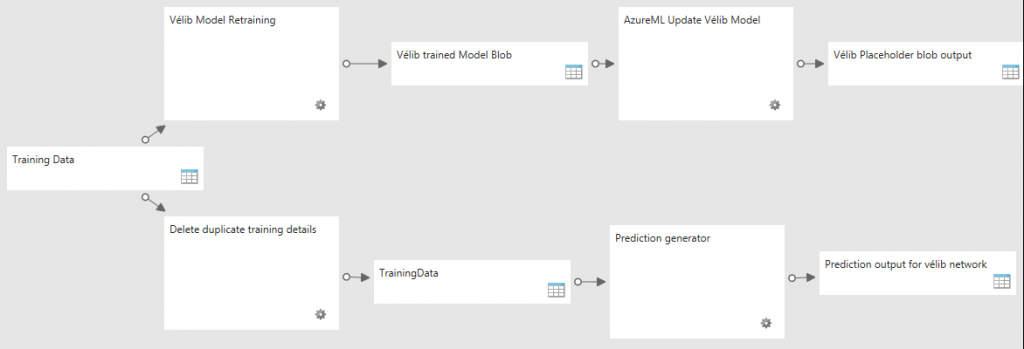

Pipeline réalisée :

Orchestration :

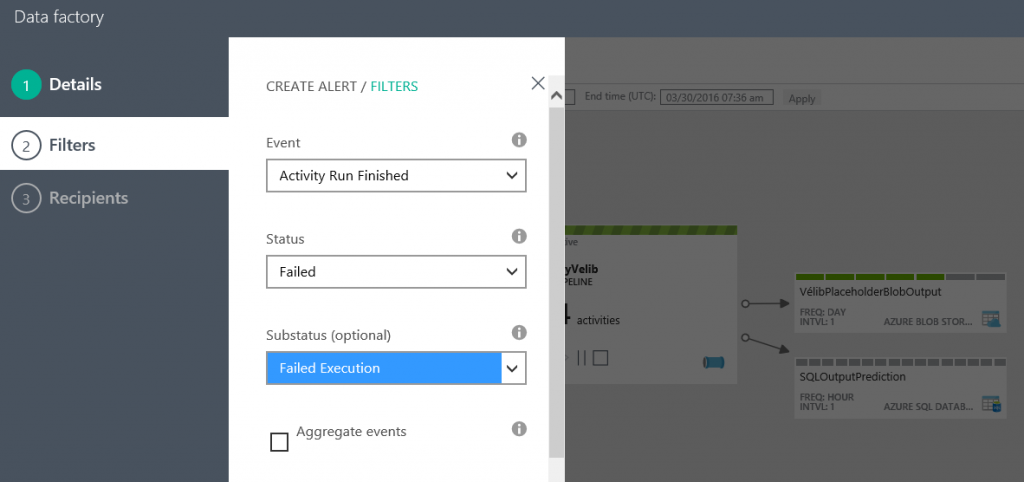

Mise en place d'une alerte:

5 - Conclusion

Dans cet article nous avons présenté la solution et la mise en place du service Azure Data Factory contenant une pipeline de quatre activités : Apel de l’API de prédiction, sauvegarder les résultats dans une base de données Azure SQL Database ainsi que pour ré entrainer et mettre a jours le modèle de prédiction.

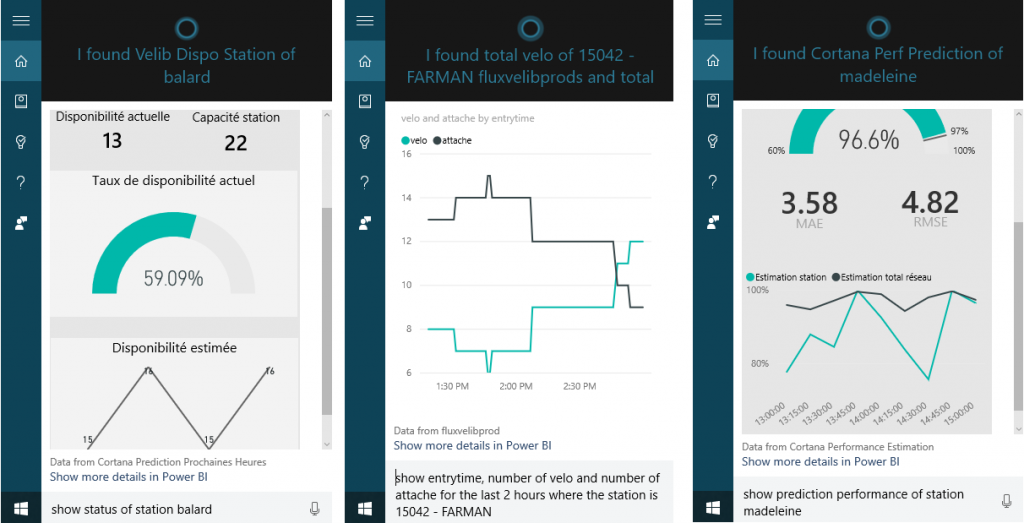

Exemples de rapports Power BI Embedded :

Voici quelques exemples de l'intégration de Power BI avec Cortana, il suffit de lui poser une question !

Nous réalisons actuellement des vidéos sur la mise en place des différentes briques, elles seront publiées sur le site Microsoft Virtual Academy.

Nous réalisons actuellement des vidéos sur la mise en place des différentes briques, elles seront publiées sur le site Microsoft Virtual Academy.

Nous participerons au prochain SQL Saturday Paris 2016 du Samedi 25 juin 2016, n'hésitez pas nous y retrouver !

Dans le prochain article, nous verrons la création du modèle de prédiction AzureML.